【毕业设计】基于大数据的抖音短视频数据分析与可视化 - python 大数据 可视化

文章目录

- 0 前言

- 1 课题背景

- 2 数据清洗

- 3 数据可视化

- 地区-用户

- 观看时间

- 分界线

- 每周观看

- 观看路径

- 发布地点

- 视频时长

- 整体点赞、完播

- 4 进阶分析

- 相关性分析

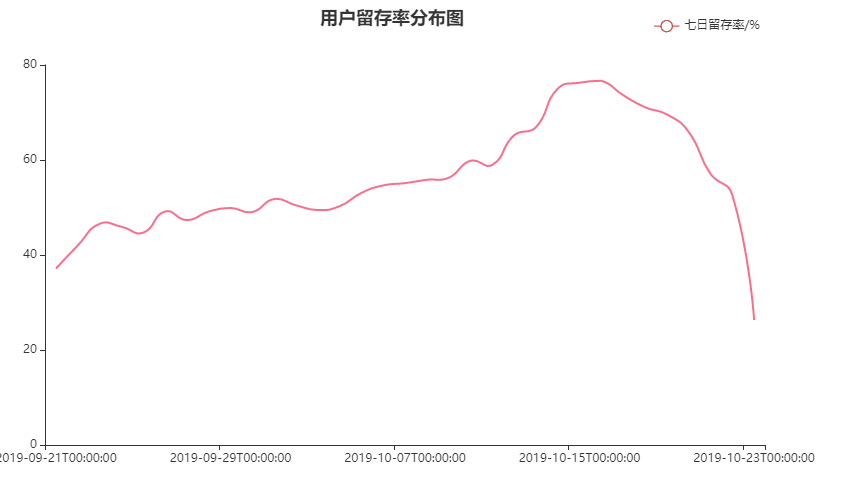

- 留存率

- 5 深度分析

- 客户价值判断

- 5 最后

0 前言

🔥 这两年开始毕业设计和毕业答辩的要求和难度不断提升,传统的毕设题目缺少创新和亮点,往往达不到毕业答辩的要求,这两年不断有学弟学妹告诉学长自己做的项目系统达不到老师的要求。

为了大家能够顺利以及最少的精力通过毕设,学长分享优质毕业设计项目,今天要分享的是

🚩 基于大数据的抖音短视频数据分析与可视化

🥇学长这里给一个题目综合评分(每项满分5分)

- 难度系数:3分

- 工作量:3分

- 创新点:3分

🧿 选题指导, 项目分享:

https://gitee.com/dancheng-senior/project-sharing-1/blob/master/%E6%AF%95%E8%AE%BE%E6%8C%87%E5%AF%BC/README.md

1 课题背景

本项目是大数据—基于抖音用户数据集的可视化分析。抖音作为当下非常热门的短视频软件,其背后的数据有极高的探索价值。本项目根据1737312条用户行为数据,利用python工具进行由浅入深的内容分析,目的是挖掘其中各类信息,更好地进行内容优化、产品运营。

2 数据清洗

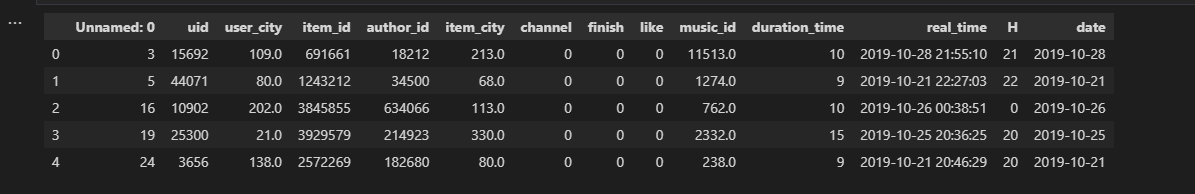

数据信息查看

简单看一下前5行数据,确定需要进一步预处理的内容:数据去重、删除没有意义的第一列,部分列格式转换、异常值检测。

# 读取数据

df = pd.read_csv('data.csv')

df.head()

df.info()

数据去重

无重复数据

print('去重前:',df.shape[0],'行数据')

print('去重后:',df.drop_duplicates().shape[0],'行数据')

缺失值查看

print(np.sum(df.isnull()))

变量类型转换

real_time 和 date 转为时间变量,id、城市编码转为字符串,并把小数点去掉

df['date'] = df['date'].astype('datetime64[ns]')

df['real_time'] = df['real_time'].astype('datetime64[ns]')

df['uid'] = df['uid'].astype('str')

df['user_city'] = df['user_city'].astype('str')

df['user_city'] = df['user_city'].apply(lambda x:x[:-2])

df['item_id'] = df['item_id'].astype('str')

df['author_id'] = df['author_id'].astype('str')

df['item_city'] = df['item_city'].astype('str')

df['item_city'] = df['item_city'].apply(lambda x:x[:-2])

df['music_id'] = df['music_id'].astype('str')

df['music_id'] = df['music_id'].apply(lambda x:x[:-2])

df.info()

3 数据可视化

基本信息的可视化,面向用户、创作者以及内容这三个维度进行,构建成分画像,便于更好地针对用户、创作者进行策略投放、内容推广与营销。

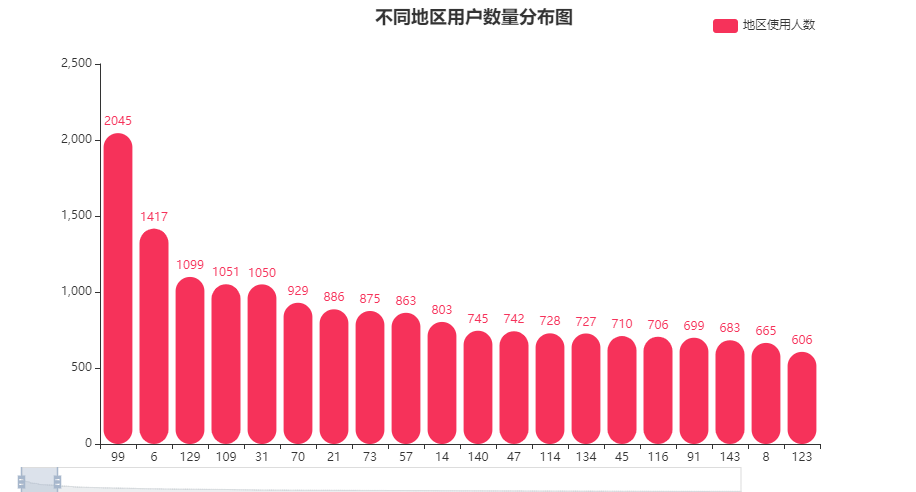

地区-用户

user_city_count = user_info.groupby(['user_city']).count().sort_values(by=['uid'],ascending=False)

x1 = list(user_city_count.index)

y1 = user_city_count['uid'].tolist()

len(y1)

不同地区用户数量分布图

#柱形图代码

chart = Bar()

chart.add_xaxis(x1)

chart.add_yaxis('地区使用人数', y1, color='#F6325A',

itemstyle_opts={'barBorderRadius':[60, 60, 20, 20]},

label_opts=opts.LabelOpts(position='top'))

chart.set_global_opts(datazoom_opts=opts.DataZoomOpts(

range_start=0,range_end=5,orient='horizontal',type_='slider',is_zoom_lock=False, pos_left='1%' ),

visualmap_opts=opts.VisualMapOpts(is_show = False,type_='opacity',range_opacity=[0.2, 1]),

title_opts=opts.TitleOpts(title="不同地区用户数量分布图",pos_left='40%'),

legend_opts=opts.LegendOpts(pos_right='10%',pos_top='2%'))

chart.render_notebook()

覆盖到了387个城市,其中编号为99的城市用户比较多超过2000人,6、129、109、31这几个城市的使用人数也超过了1000。

- 可以关注用户较多城市的特点,对产品受众有进一步的把握。

- 用户较少的城市可以视作流量洼地,考虑进行地推/用户-用户的推广,增加地区使用人数。

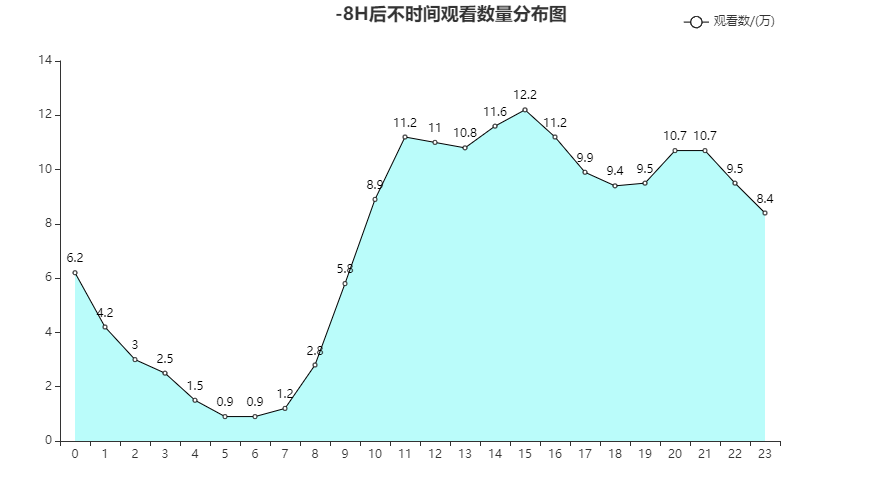

观看时间

h_num = round((df.groupby(['H']).count()['uid']/10000),1).to_list()

h = list(df.groupby(['H']).count().index)

不同时间观看数量分布图

chart = Line()

chart.add_xaxis(h)

chart.add_yaxis('观看数/(万)',h_num, areastyle_opts=opts.AreaStyleOpts(color = '#1AF5EF',opacity=0.3),

itemstyle_opts=opts.ItemStyleOpts(color='black'),

label_opts=opts.LabelOpts(font_size=12))

chart.set_global_opts(legend_opts=opts.LegendOpts(pos_right='10%',pos_top='2%'),

title_opts=opts.TitleOpts(title="不时间观看数量分布图",pos_left='40%'),)

chart.render_notebook()

去掉时差后

根据不同时间的观看视频数量来看,11-18,20-21,尤其是13-16是用户使用的高峰期

- 在用户高浏览的时段进行广告的投放,曝光量更高

- 在高峰段进行优质内容的推荐,效果会更好

分界线

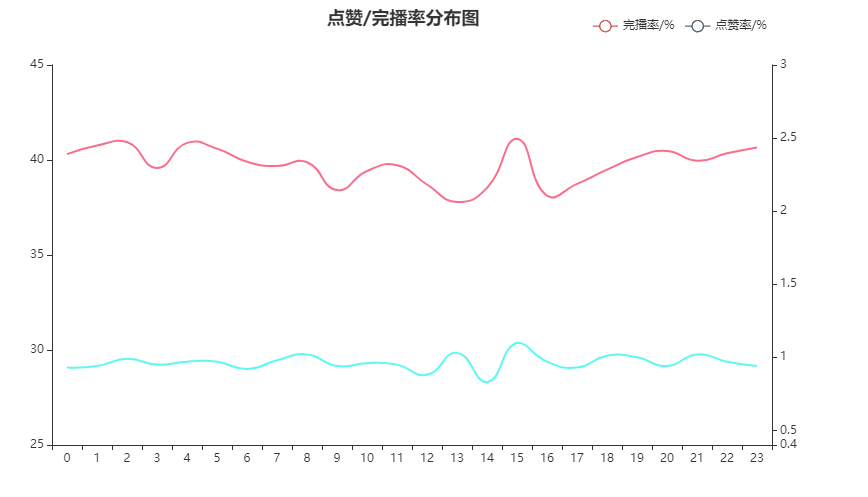

点赞/完播率分布图

left = df.groupby(['H']).sum()[['finish','like']]

right = df.groupby(['H']).count()['uid']

per = pd.concat([left,right],axis=1)

per['finish_radio'] = round(per['finish']*100/per['uid'],2)

per['like_radio'] = round(per['like']*100/per['uid'],2)

x = list(df.groupby(['H']).count().index)

y1 = per['finish_radio'].to_list()

y2 = per['like_radio'].to_list()

#建立一个基础的图形

chart1 = Line()

chart1.add_xaxis(x)

chart1.add_yaxis('完播率/%',y1,is_smooth=True,label_opts=opts.LabelOpts(is_show=False),is_symbol_show = False,

linestyle_opts=opts.LineStyleOpts(color='#F6325A',opacity=.7,curve=0,width=2,type_= 'solid' ))

chart1.set_global_opts(yaxis_opts = opts.AxisOpts(min_=25,max_=45))

chart1.extend_axis(yaxis=opts.AxisOpts(min_=0.4,max_=3))

#叠加折线图

chart2 = Line()

chart2.add_xaxis(x)

chart2.add_yaxis('点赞率/%',y2,yaxis_index=1,is_smooth=True,label_opts=opts.LabelOpts(is_show=False),is_symbol_show = False,

linestyle_opts=opts.LineStyleOpts(color='#1AF5EF',opacity=.7,curve=0,width=2,type_= 'solid' ))

chart1.overlap(chart2)

chart1.set_global_opts(legend_opts=opts.LegendOpts(pos_right='10%',pos_top='2%'),

title_opts=opts.TitleOpts(title="点赞/完播率分布图",pos_left='40%'),)

chart1.render_notebook()

关注到点赞率和完播率,这两个与用户粘性、创作者收益有一定关系的指标。可以看到15点是两个指标的小高峰,2、4、20、23完播较高,8、13、18、20点赞率较高。但结合观看数量与时间段的分布图,大致猜测15点深度用户较多。

- 关注深度用户特点,思考如何增加普通用户的完播、点赞

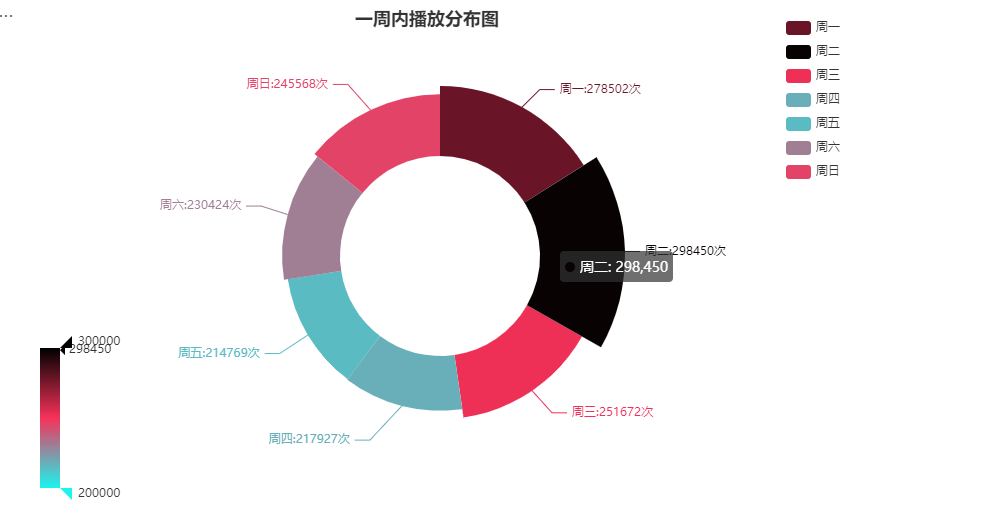

每周观看

df['weekday'] = df['date'].dt.weekday

week = df.groupby(['weekday']).count()['uid'].to_list()

df_pair = [['周一', week[0]], ['周二', week[1]], ['周三', week[2]], ['周四', week[3]], ['周五', week[4]], ['周六', week[5]], ['周日', week[6]]]

chart = Pie()

chart.add('', df_pair,radius=['40%', '70%'],rosetype='radius',center=['45%', '50%'],label_opts=opts.LabelOpts(is_show=True,formatter = '{b}:{c}次'))

chart.set_global_opts(visualmap_opts=[opts.VisualMapOpts(min_=200000,max_=300000,type_='color', range_color=['#1AF5EF', '#F6325A', '#000000'],is_show=True,pos_top='65%')],

legend_opts=opts.LegendOpts(pos_right='10%',pos_top='2%',orient='vertical'),

title_opts=opts.TitleOpts(title="一周内播放分布图",pos_left='35%'),)

chart.render_notebook()

在统计的时间内周一到周三观看人数较多,但总体观看次数基本在20-30w之间。

- 创作者选择在周一-三这几天分布可能会收获更多的观看数量

观看路径

df.groupby(['channel']).count()['uid']

观看途径主要以1为主,初步猜测为App。3途径也有部分用户使用,可能为浏览器。

- 考虑拓宽各个观看渠道,增加总体播放量和产品使用度

- 非主渠道观看,制定策略提升转化,将流量引入主渠道

- 针对主要渠道内容进行商业化策略投放,效率更高

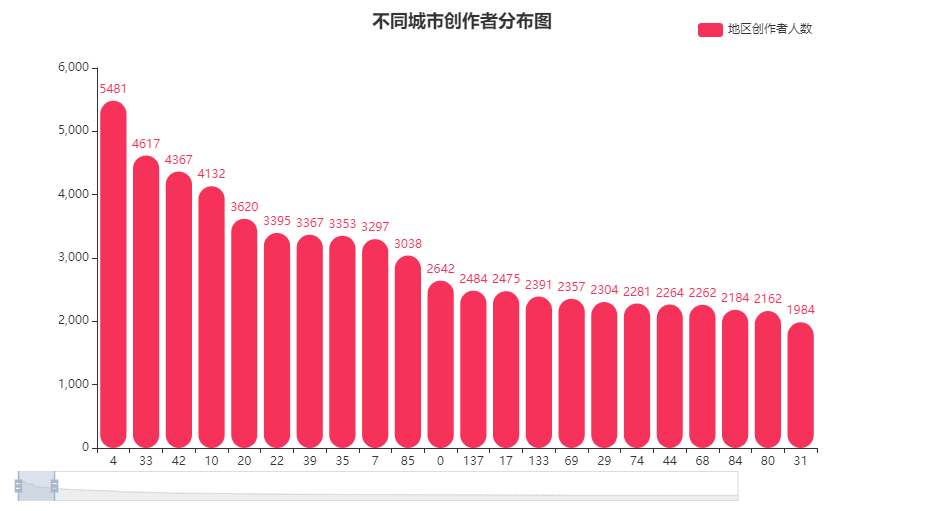

发布地点

author_info = df.drop_duplicates(['author_id','item_city'])[['author_id','item_city']]

author_info.info()

author_city_count = author_info.groupby(['item_city']).count().sort_values(by=['author_id'],ascending=False)

x1 = list(author_city_count.index)

y1 = author_city_count['author_id'].tolist()

df.drop_duplicates(['author_id']).shape[0]

不同城市创作者分布图

chart = Bar()

chart.add_xaxis(x1)

chart.add_yaxis('地区创作者人数', y1, color='#F6325A',

itemstyle_opts={'barBorderRadius':[60, 60, 20, 20]})

chart.set_global_opts(datazoom_opts=opts.DataZoomOpts(

range_start=0,range_end=5,orient='horizontal',type_='slider',is_zoom_lock=False, pos_left='1%' ),

visualmap_opts=opts.VisualMapOpts(is_show = False,type_='opacity',range_opacity=[0.2, 1]),

legend_opts=opts.LegendOpts(pos_right='10%',pos_top='2%'),

title_opts=opts.TitleOpts(title="不同城市创作者分布图",pos_left='40%'))

chart.render_notebook()

观看用户地区分布和创作者分布其实存在不对等的情况。4地区创作者最多,超5k人,33、42、10地区创作者也较多。

- 创作者与地区的联系也值得关注,尤其是创作内容如果和当地风俗环境人文有关

- 相邻近地区的优质的创作者之间互动,可以更好的引流

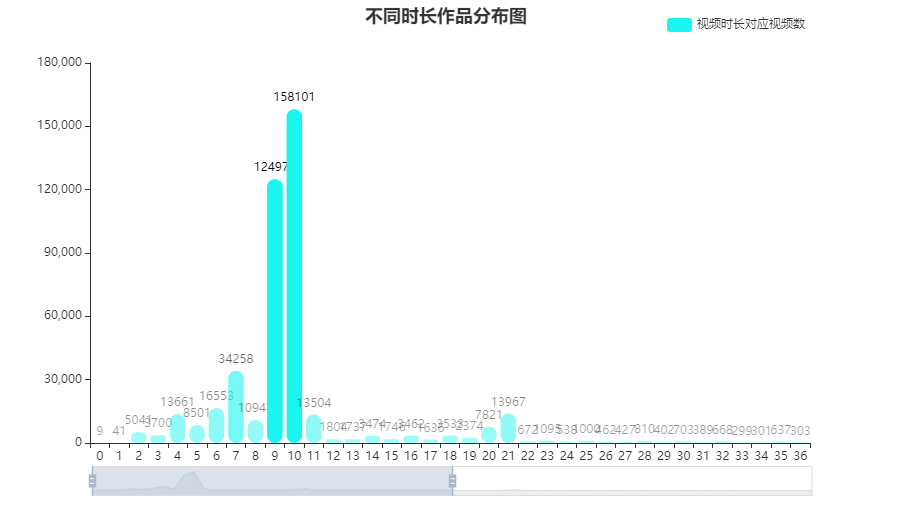

视频时长

time = df.drop_duplicates(['item_id'])[['item_id','duration_time']]

time = time.groupby(['duration_time']).count()

x1 = list(time.index)

y1 = time['item_id'].tolist()

不同时长作品分布图

chart = Bar()

chart.add_xaxis(x1)

chart.add_yaxis('视频时长对应视频数', y1, color='#1AF5EF',

itemstyle_opts={'barBorderRadius':[60, 60, 20, 20]},

label_opts=opts.LabelOpts(font_size=12, color='black'))

chart.set_global_opts(datazoom_opts=opts.DataZoomOpts(

range_start=0,range_end=50,orient='horizontal',type_='slider'),

visualmap_opts=opts.VisualMapOpts(max_=100000,min_=200,is_show = False,type_='opacity',range_opacity=[0.4, 1]),

legend_opts=opts.LegendOpts(pos_right='10%',pos_top='2%'),

title_opts=opts.TitleOpts(title="不同时长作品分布图",pos_left='40%'))

chart.render_notebook()

视频时长主要集中在9-10秒,符合抖音“短”视频的特点。

- 官方提供9/10秒专用剪视频模板,提高创作效率

- 创作者关注创意浓缩和内容提炼

- 视频分布在这两个时间点的爆发也能侧面反映用户刷视频的行为特征

整体点赞、完播

like_per = 100*np.sum(df['like'])/len(df['like'])

finish_per = 100*np.sum(df['finish'])/len(df['finish'])

gauge = Gauge()

gauge.add("",[("视频互动率", like_per),['完播率',finish_per]],detail_label_opts=opts.LabelOpts(is_show=False,font_size=18),

axisline_opts=opts.AxisLineOpts(linestyle_opts=opts.LineStyleOpts(

color=[(0.3, "#1AF5EF"), (0.7, "#F6325A"), (1, "#000000")],width=20)))

gauge.render_notebook()

内容整体完播率非常接近40%,点赞率在1%左右

- 用户更多是“刷”视频,挖掘吸引力和作品连贯性,能更好留住用户

- 点赞功能挖掘不够,可尝试进行ABtest,对点赞按钮增加动画,测试是否会提升点赞率

4 进阶分析

相关性分析

df_cor = df[['finish','like','duration_time','H']] # 只选取部分

cor_table = df_cor.corr(method='spearman')

cor_array = np.array(cor_table)

cor_name = list(cor_table.columns)

value = [[i, j, cor_array[i,j]] for i in [3,2,1,0] for j in [0,1,2,3]]

heat = HeatMap()

heat.add_xaxis(cor_name)

heat.add_yaxis("",cor_name,value,label_opts=opts.LabelOpts(is_show=True, position="inside"))

heat.set_global_opts(visualmap_opts=opts.VisualMapOpts(is_show=False, max_=0.08, range_color=["#1AF5EF", "#F6325A", "#000000"]))

heat.render_notebook()

因为变量非连续,采取spearman相关系数,制作相关性热力图。由于数据量比较大的缘故,几个数量性变量之间的相关性都比较小,其中看到finish和点赞之间的相关系数稍微大一些,可以一致反映用户对该视频的偏好。

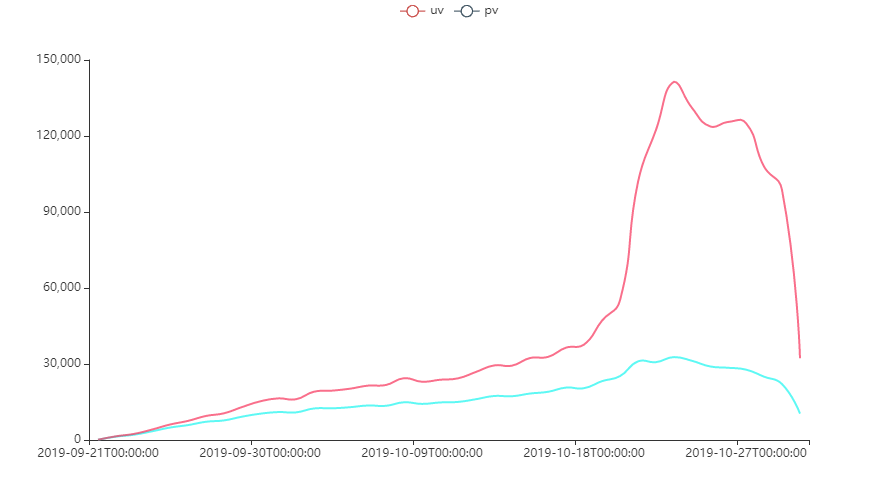

留存率

pv/uv

temp = df['date'].to_list()

puv = df.groupby(['date']).agg({'uid':'nunique','item_id':'count'})

uv = puv['uid'].to_list()

pv = puv['item_id'].to_list()

time = puv.index.to_list()

chart1 = Line()

chart1.add_xaxis(time)

chart1.add_yaxis('uv',uv,is_smooth=True,label_opts=opts.LabelOpts(is_show=False),is_symbol_show = False,

linestyle_opts=opts.LineStyleOpts(color='#1AF5EF',opacity=.7,curve=0,width=2,type_= 'solid' ))

chart1.add_yaxis('pv',pv,is_smooth=True,label_opts=opts.LabelOpts(is_show=False),is_symbol_show = False,

linestyle_opts=opts.LineStyleOpts(color='#F6325A',opacity=.7,curve=0,width=2,type_= 'solid' ))

chart1.render_notebook()

在2019.10.18进入用户使用高峰阶段,目标用户单人每天浏览多个视频。

- 关注高峰时间段,是否是当下推荐算法起作用了

7/10 留存率

lc = []

for i in range(len(time)-7):

bef = set(list(df[df['date']==time[i]]['uid']))

aft = set(list(df[df['date']==time[i+7]]['uid']))

stay = bef&aft

per = round(100*len(stay)/len(bef),2)

lc.append(per)

lc1 = []

for i in range(len(time)-1):

bef = set(list(df[df['date']==time[i]]['uid']))

aft = set(list(df[df['date']==time[i+1]]['uid']))

stay = bef&aft

per = round(100*len(stay)/len(bef),2)

lc1.append(per)

x7 = time[0:-7]

chart1 = Line()

chart1.add_xaxis(x7)

chart1.add_yaxis('七日留存率/%',lc,is_smooth=True,label_opts=opts.LabelOpts(is_show=False),is_symbol_show = False,

linestyle_opts=opts.LineStyleOpts(color='#F6325A',opacity=.7,curve=0,width=2,type_= 'solid' ))

chart1.set_global_opts(legend_opts=opts.LegendOpts(pos_right='10%',pos_top='2%'),

title_opts=opts.TitleOpts(title="用户留存率分布图",pos_left='40%'),)

chart1.render_notebook()

用户留存率保持在40%+,且没有跌破30%,说明获取到的数据中忠实用户较多。

- 存在一定可能性是因为数据只爬取了特定用户群体的行为数据,结合创作者数量>用户数量可得到验证

- 但一定程度可以反映软件留存这块做的不错

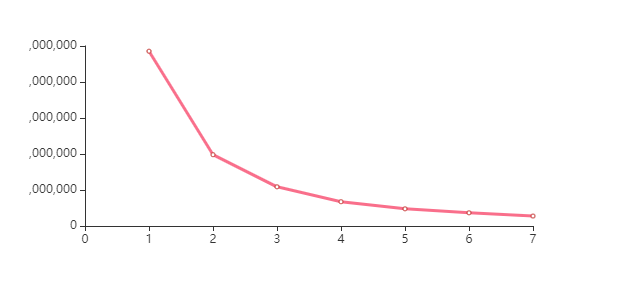

5 深度分析

客户价值判断

通过已观看数、完播率、点赞率进行用户聚类,价值判断

df1 = df.groupby(['uid']).agg({'item_id':'count','like':'sum','finish':'sum'})

df1['like_per'] = df1['like']/df1['item_id']

df1['finish_per'] = df1['finish']/df1['item_id']

ndf1 = np.array(df1[['item_id','like_per','finish_per']])#.shape

kmeans_per_k = [KMeans(n_clusters=k).fit(ndf1) for k in range(1,8)]

inertias = [model.inertia_ for model in kmeans_per_k]

chart = Line(init_opts=opts.InitOpts(width='560px',height='300px'))

chart.add_xaxis(range(1,8))

chart.add_yaxis("",inertias,label_opts=opts.LabelOpts(is_show=False),

linestyle_opts=opts.LineStyleOpts(color='#F6325A',opacity=.7,curve=0,width=3,type_= 'solid' ))

chart.render_notebook()

n_cluster = 4

cluster = KMeans(n_clusters=n_cluster,random_state=0).fit(ndf1)

y_pre = cluster.labels_ # 查看聚好的类

from sklearn.metrics import silhouette_score

from sklearn.metrics import silhouette_samples

silhouette_score(ndf1,y_pre)

n_cluster = 3

cluster = KMeans(n_clusters=n_cluster,random_state=0).fit(ndf1)

y_pre = cluster.labels_ # 查看聚好的类

from sklearn.metrics import silhouette_score

from sklearn.metrics import silhouette_samples

silhouette_score(ndf1,y_pre)

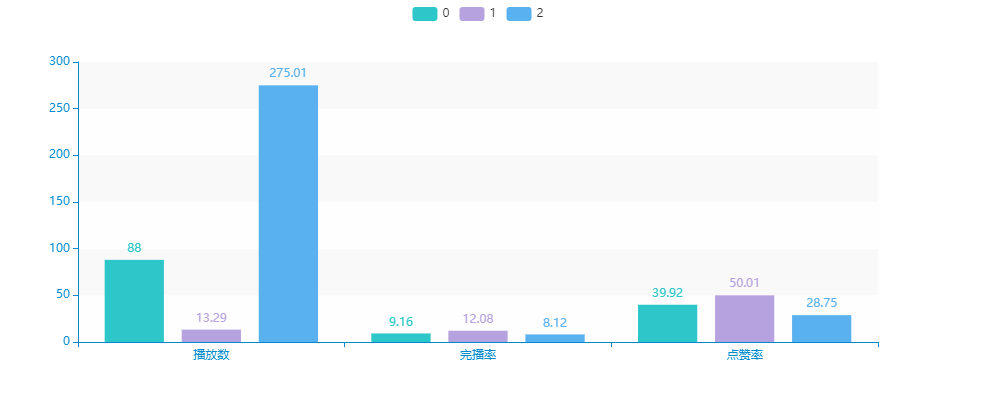

比较三类、四类的轮廓系数,确定聚为3类

c_ = [[],[],[]]

c_[0] = [87.998,9.1615,39.92]

c_[1] = [13.292,12.077,50.012]

c_[2] = [275.011,8.125,28.751]

bar = Bar(init_opts=opts.InitOpts(theme='macarons',width='1000px',height='400px')) # 添加分类(x轴)的数据

bar.add_xaxis(['播放数','点赞率(千分之)','完播率(百分之)'])

bar.add_yaxis('0', [round(i,2) for i in c_[0]], stack='stack0')

bar.add_yaxis('1',[round(i,2) for i in c_[1]], stack='stack1')

bar.add_yaxis('2',[round(i,2) for i in c_[2]], stack='stack2')

bar.render_notebook()

可以大致对三类的内容做一个描述。

- 紫色 - 观看数量较少,但点赞完播率都非常高的:对内容观看有耐心,愿意产生额外性行为。因此通过观看兴趣内容打散、可以刺激用户观看更多视频。e.g.多推荐有悬念、连续性的短视频

- 绿色 - 观看数量适中,点赞率、完播率有所下滑,对这类用户的策略可以中和先后两种。

- 蓝色 - 观看数量非常多,点赞、完播率教室,这类用户更多会关注到视频前半段的内容,兴趣点可通过停留时间进行判断,但使用时间相对较长,反映产品依赖性,一定程度上来说算是核心用户。e.g.利用停留时间判断喜好,优化推荐算法,重点推荐前半段内容吸引力大的。

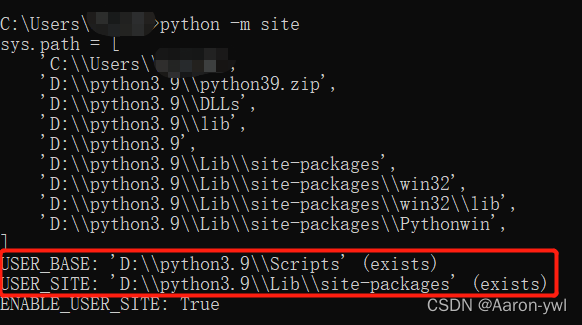

5 最后

相关文章:

修改pip安装路径的方法

当我们需要安装python的第三方库时,通常都是打开cmd输入pip install xxx去安装。 但是默认安装路径在C盘,极大占用空间,看看我的C盘空间,已经不足了!!! 所以我们修改pip的安装路径这个步骤是很…...

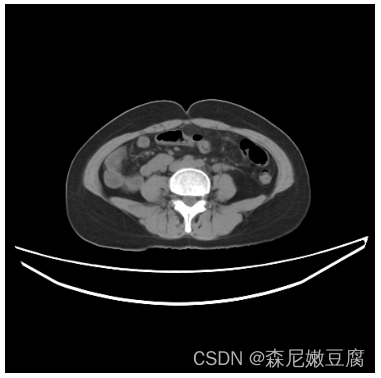

Python CT图像预处理——nii格式读取、重采样、窗宽窗位设置

文章目录nii格式CT数据读取读写nii格式文件查看重采样窗宽窗位设置方法一:手动设置窗宽窗位方法二:nii格式CT数据读取 遇到nii格式的CT数据,可以通过nibabel包进行数据的读、写、查看等操作。下面列出常见操作。 读写nii格式文件 nibabel读…...

python学生成绩管理系统【完整版】

✅作者简介:大家好我是hacker707,大家可以叫我hacker,新星计划第三季python赛道Top1🏆 📃个人主页:hacker707的csdn博客 🔥系列专栏:python 💬推荐一款模拟面试、刷题神器Ǵ…...

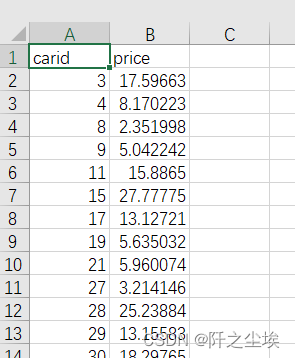

Python数据分析案例07——二手车估价(机器学习全流程,数据清洗、特征工程、模型选择、交叉验证、网格搜参、预测储存)

案例背景 本次案例来自2021年matchcop大数据竞赛A题数据集。要预测二手车的价格。训练集3万条数据,测试集5千条。官方给了二手车的很多特征,有的是已知的,有的是匿名的。要求就是做模型去预测测试集的二手车的价格。价格是一个连续变量&…...

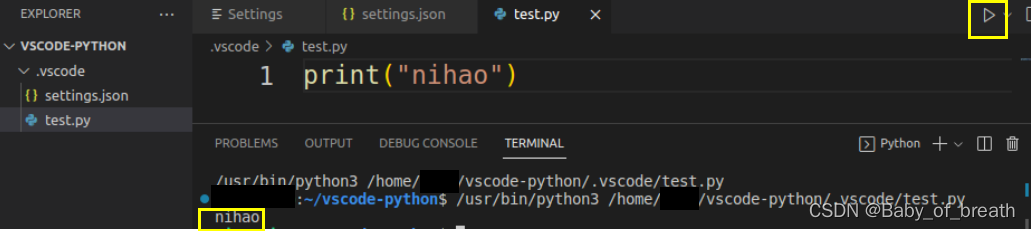

vscode运行python程序

系统:Ubuntu18.04 一、安装python插件 打开vscode,找到最右侧的Extensions,在上方搜索栏搜索python如大红框所圈,点击Install,安装即可。 二、创建python项目(.py存放的文件夹) 笔者习惯存放…...

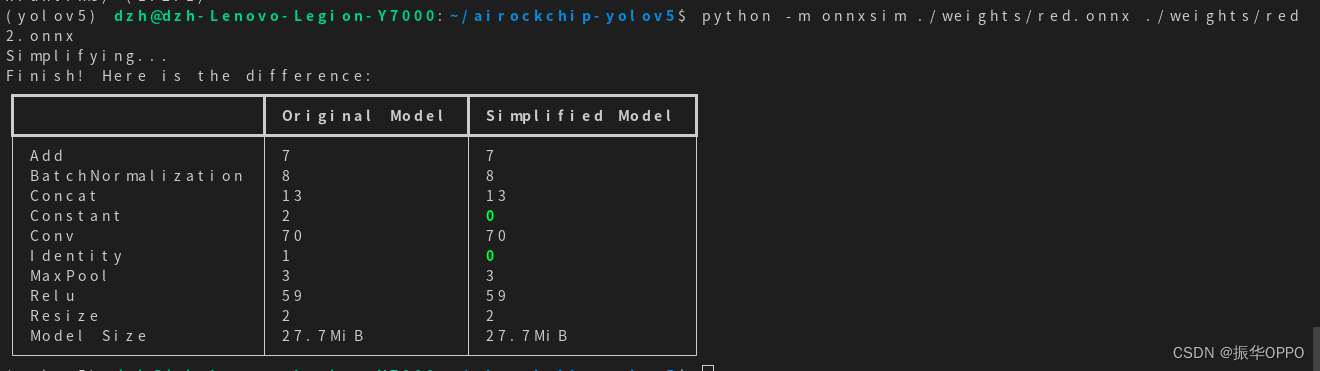

【yolov5】pytorch模型导出为onnx模型

博主想拿官网的yolov5训练好pt模型,然后转换成rknn模型,然后在瑞芯微开发板上调用模型检测。但是官网的版本对npu不友好,所以采用改进结构的版本: 将Focus层改成Conv层将Swish激活函数改成Relu激活函数 自带的预训练模型是预测80类…...

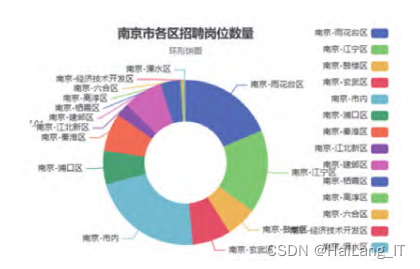

毕业设计-基于大数据招聘岗位可视化系统-python

目录 前言 课题背景和意义 实现技术思路 实现效果图样例 前言 📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科…...

No module named ‘cv2‘ 解决办法 (No module named ‘numpy‘ 等所有报错均可解决)

实在不行可以私信我解决! 1.关于离线pip install 库爆winErro[10061]的问题原因 使用了局域网,没有链接到网络 1.1 解决方法: 1.链接网络 2.假如离线安装 pip install imgaug.whl 库,但是imgaug依赖 shapely库。因此要安装imgaug库之前&…...

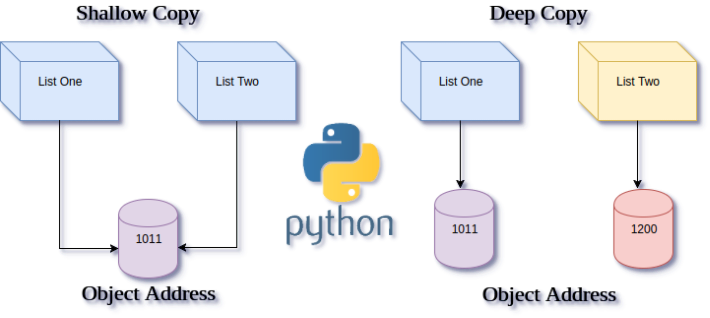

详细分析Python中深浅拷贝的区别

简而言之: 深浅拷贝的区别关键在于拷贝的对象类型是否可变。 我们可以总结出以下三条规则: 对于可变对象来说,深拷贝和浅拷贝都会开辟新地址,完成对象的拷贝而对于不可变对象来说,深浅拷贝都不会开辟新地址ÿ…...

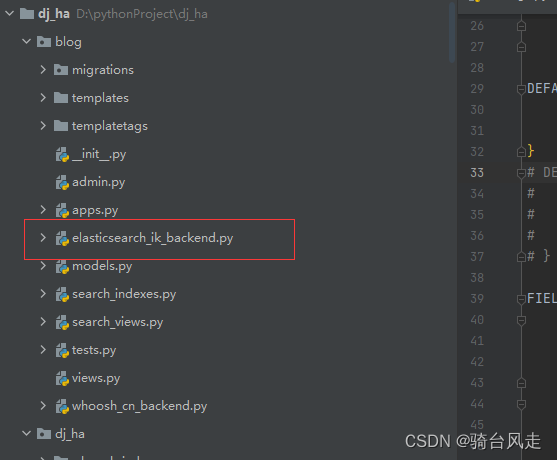

django+drf_haystack+elasticsearch+ik+高亮显示

0.前提准备 环境 1. 准备好django2.2 2. 创建一个app 3.elasticsearch7.5启动 4.可视化工具(实在没有,也没啥) models.py from django.db import models# Create your models here.class Article(models.Model):title models.CharField(verbose_name文章标题, max_length22…...

头歌Python数据框、序列定义及数据处理应用实验闯关

粘贴答案不是目的 把Python学会这才叫做意义 童年的纸飞机 现在终于飞回我手里~~ 文章目录第1关:序列和数据框第2关:外部数据文件读取第3关:逻辑索引、切片方法,groupby 分组计算函数应用第4关:数据框关联操作第5关…...

使用pip下载时提示“You are using pip version 8.1.1, however version 22.1 is available.“

在使用pip install下载其他包时,报了错,如图: 提示:“You are using pip version 8.1.1, however version 22.1 is available. You should consider upgrading via the ‘pip install --upgrade pip’ command.” 根据提示&#…...

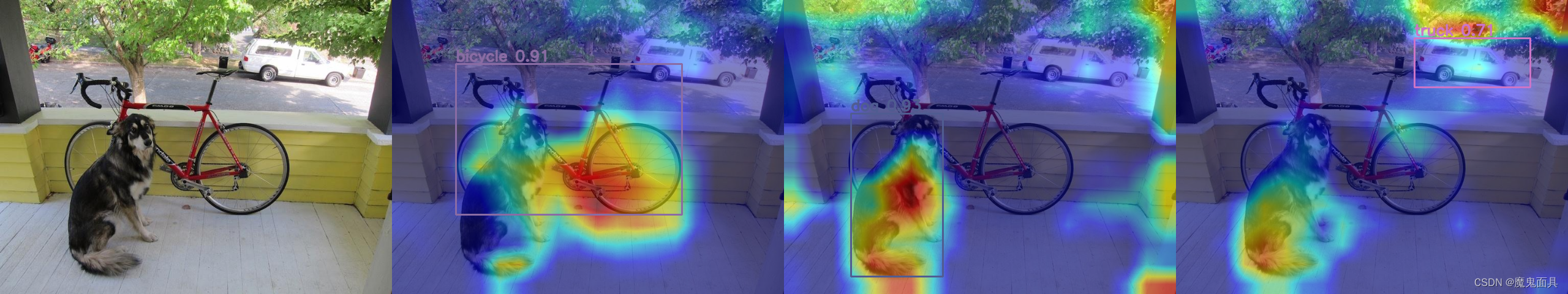

YOLOV8-gradcam 热力图可视化 即插即用 不需要对源码做任何修改!

YOLOV8 GradCam 热力图可视化. 本文给大家带来yolov8-gradcam热力图可视化,这个可视化是即插即用,不需要对源码做任何修改喔!给您剩下的不少麻烦! 代码链接:yolo-gradcam 里面还有yolov5和v7的热力图可视化代码&#…...

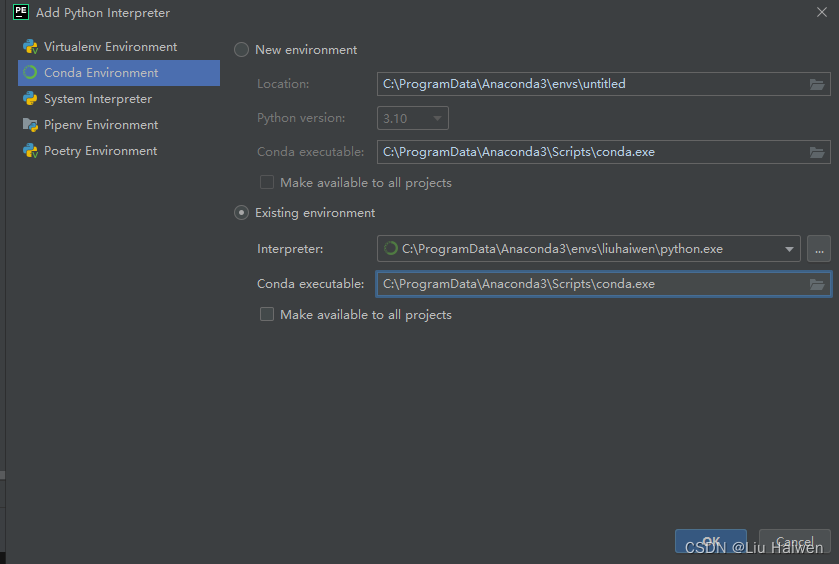

Anaconda创建虚拟环境并在Pycharm中使用创建好的环境

Anaconda创建虚拟环境并在Pycharm中使用创建好的环境1.Anaconda创建虚拟环境2.Pycharm中使用创建好的环境3.2022.12.8更新Anaconda的优势在于可以很方便地管理自己的工具包、开发环境和Python版本,同时还能使用不同的虚拟环境隔离不同要求的项目。假如你已经安装好了…...

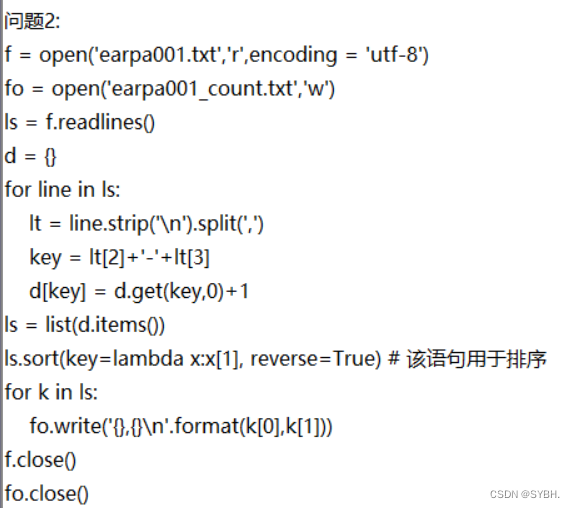

python二级题库(百分之九十原题) 刷题软件推荐 第二套

目录 一、选择题 二、基本操作 三、简单应用 四、综合应用 刷题软件(模拟python二级考试): 公众h:露露IT 回复:python二级 一、选择题 1、下列叙述中正确的是()。 A.在栈中,栈…...

【模拟 简易银行系统~python】

目录~python面向对象编程之模拟银行系统相关程序代码如下:运行效果如下:pandas 每日一练:运行结果为:66、绘制sku_cost_prc的密度曲线运行效果为:67、计算后一天与前一天sku_cost_prc的差值运行结果为:68、…...

【YOLOv7/YOLOv5系列改进NO.52】融入YOLOv8中的C2f模块

文章目录 前言一、解决问题二、基本原理三、YOLOv5添加方法四、YOLOv7添加方法五、总结前言 作为当前先进的深度学习目标检测算法YOLOv7,已经集合了大量的trick,但是还是有提高和改进的空间,针对具体应用场景下的检测难点,可以不同的改进方法。此后的系列文章,将重点…...

PyTorch 单机多GPU 训练方法与原理整理

PyTorch 单机多GPU 训练方法与原理整理 这里整理一些PyTorch单机多核训练的方法和简单原理,目的是既能在写代码时知道怎么用,又能从原理上知道大致是怎么回事儿。 就目前来说,并行训练的方法可以根据的不同的并行对象分为——模型并行和数据…...

anaconda创建、删除虚拟环境指令

使用conda创建、删除虚拟环境指令{\color{Red}使用conda创建、删除虚拟环境指令}使用conda创建、删除虚拟环境指令 使用conda创建、删除虚拟环境指令{\color{Red}使用conda创建、删除虚拟环境指令}使用conda创建、删除虚拟环境指令 一、创建虚拟环境 二、查看虚拟环境 三、激活…...

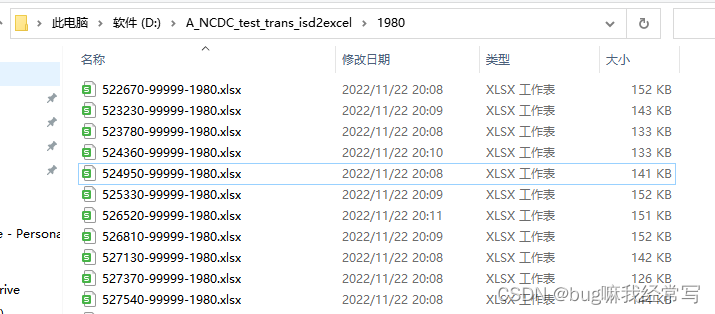

NCDC气象数据的提取与处理(二):python批量转换isd-lite数据为xlsx

目录 1.完整代码(部分代码参考https://zhuanlan.zhihu.com/p/556150264) 2.工作过程 2.1输入 2.2过程 3.实际效果 本例使用的相关数据及代码可见 链接:https://pan.baidu.com/s/1EYE0U7RrHSGGk3vptZyNVg 提取码:6666 书接上…...

MD5密码实验——Python实现(完整解析版)

文章目录更新:前言实验环境实验内容实验操作步骤1.初始化四个缓冲区2.设置常数表、位移位数等参数3.增加填充4.分组处理5.输出处理实验结果实验心得实验代码MD5-Python.py更新: 感谢评论区的大佬指出错误,现已改进代码 之前的错误在于没有考…...

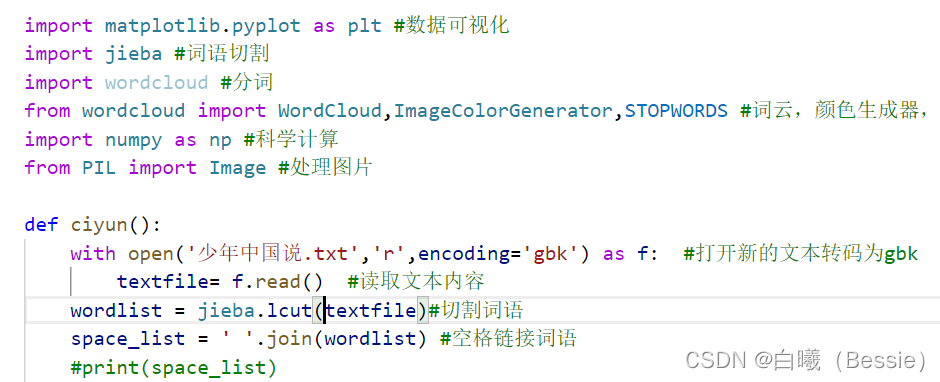

如何在vscode中下载python第三方库(jieba和wordcloud为例)

本文由来 本来我并不想写文章的,但是我发现,对于一个0基础的小白vscode用户而言,想完整的下载一个第三方库还是存在一定的问题,并且我在搜索文章的时候发现,完全没有小白教程,太难了,所以说我就…...

python安装使用pip安装numpy

相信大家最近都在忙,因为到开学和上班的时候了,我最近也很忙,忙的快要流泪,这不是要考计算机三级了吗!买了好厚一本书,备战过程中,最近洗头一次掉了100根不止的头发,有点恐惧&#x…...

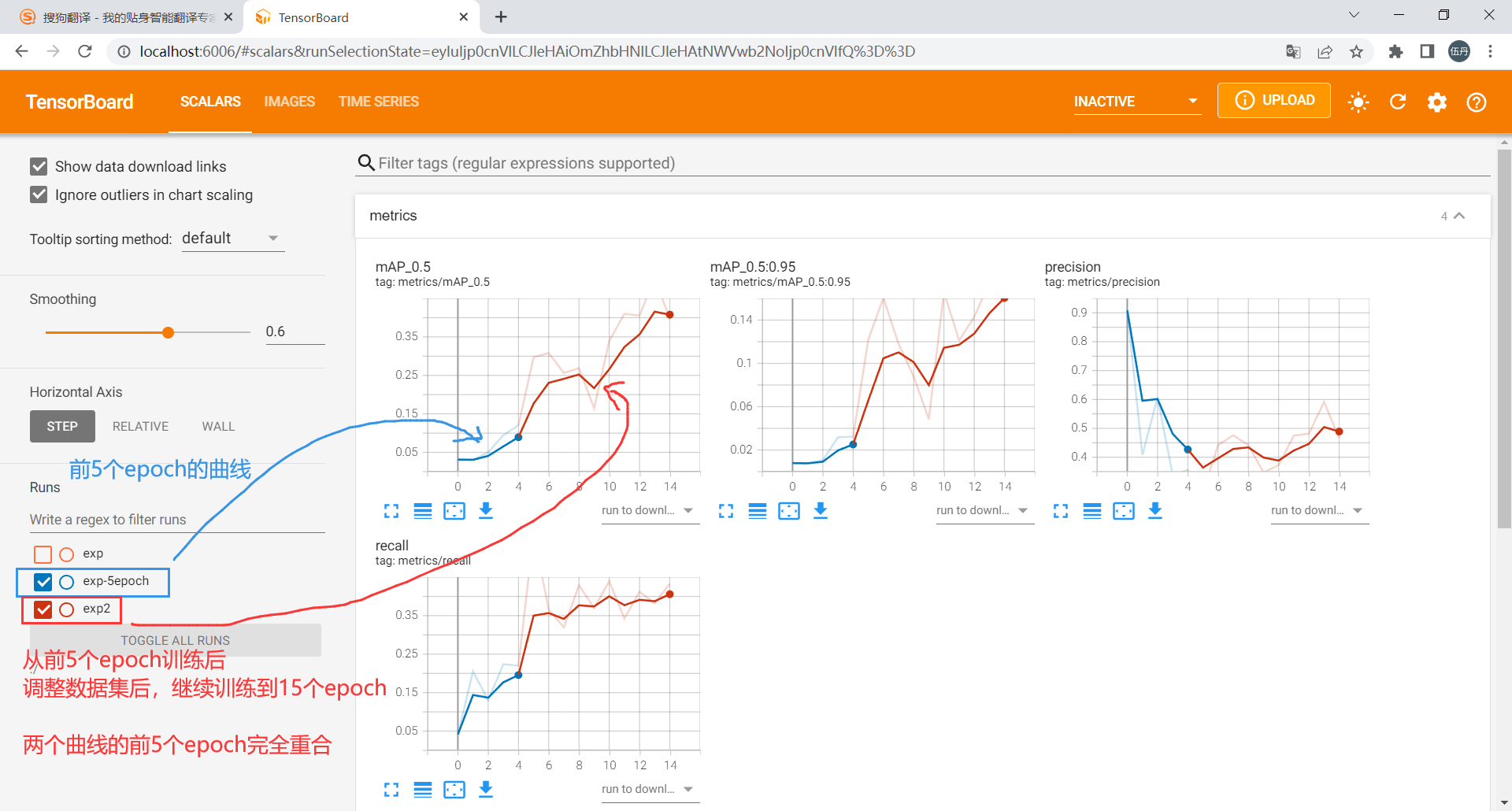

yolov5ds-断点训练、继续训练、先终止训练并调整最终epoch(yolov5同样适用)

目录参考链接1. 训练过程中中断了,继续训练如果觉得数值差不多稳定了,但是距离最终设置的epoch还很远,所以想要停止训练但是又得到yolov5在运行完指定最大epoch后生成的一系列map、混淆矩阵等图2. 训练完原有epoch,但还继续训练&a…...

openCV第一篇

文章目录 前言:计算机眼中的图片 1. 图片的读取与显示 1.1 图片的读取 1.2 显示的图片 1.2.1 显示原始图片 1.2.2 灰度图 1.3 BGR转换成灰度图、RGB 2. 保存图片 3. 视频的读取与显示 4. 截取图像部分 5. 颜色通道提取 6. 边界填充 7. 数值计算 8.…...

基于Python构建机器学习Web应用

目录 一、内容介绍 1.Onnx模型 ①skl2onnx库安装 2.Netron安装 二、模型构建 1.数据加载 2.划分可训练特征与预测标签 3.训练模型 ①第三方库导入 ②数据集划分 ③SVC模型构建 ④精度评价 二、模型转换及可视化 1.参数配置 2.Onnx模型生成 3.可视化模型 四、构…...

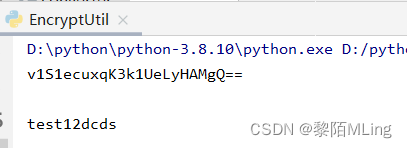

python - 密码加密与解密

Python之密码加密与解密 - 对称算法一、对称加密1.1 安装第三方库 - PyCrypto1.2 加密实现二、非对称加密三、摘要算法3.1 md5加密3.2 sha1加密3.3 sha256加密3.4 sha384加密3.5 sha512加密3.6 “加盐”加密由于计算机软件的非法复制,通信的泄密、数据安全受到威胁。…...

百度飞桨PaddleSpeech的简单使用

PaddleSpeech 是基于飞桨 PaddlePaddle 的语音方向的开源模型库,用于语音和音频中的各种关键任务的开发,包含大量基于深度学习前沿和有影响力的模型,一些典型的应用示例如下:语音识别、语音翻译 (英译中)、语音合成、标点恢复等。…...

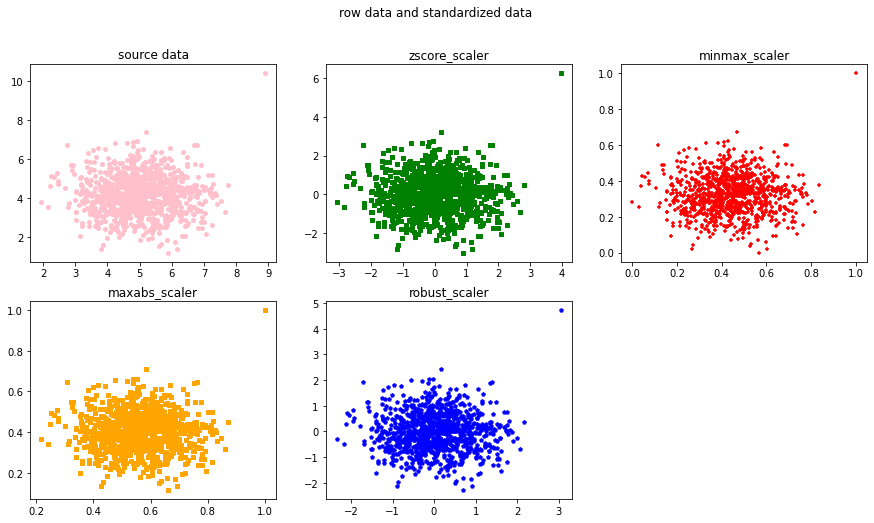

Python数据标准化

目录 一.数据标准化方式 1.实现中心化和正态分布的Z-Score 2.实现归一化的Max-Min 3.用于稀疏数据的MaxAbs 4.针对离群点的RobustScaler 二.Python针对以上几种标准化方法处理数据 三.总结 一.数据标准化方式 1.实现中心化和正态分布的Z-Score Z-Score标准化是基于原…...

Pycharm无法下载汉化包,一招教你搞定

Pycharm无法下载汉化包,一招教你搞定Pycharm直接导入汉化包Pycharm 无法采用自带的插件安装汉化包Pycharm直接导入汉化包 Pycharm 是可以直接导入汉化包的,这为很多初学者省区了不少麻烦。具体就是: 1:点击pycharm界面右上角的设…...

python成功实现“高配版”王者小游戏?【赠源码】

前言 嗨喽~大家好呀,这里是魔王呐 ❤ ~! 本游戏完整源码、素材: 点击此处跳转文末名片获取 咳咳,又是一款新的小游戏,就是大家熟悉的王者~ 来看我用python来实现高(di)配版的王者 是一款拿到代码运行后,…...

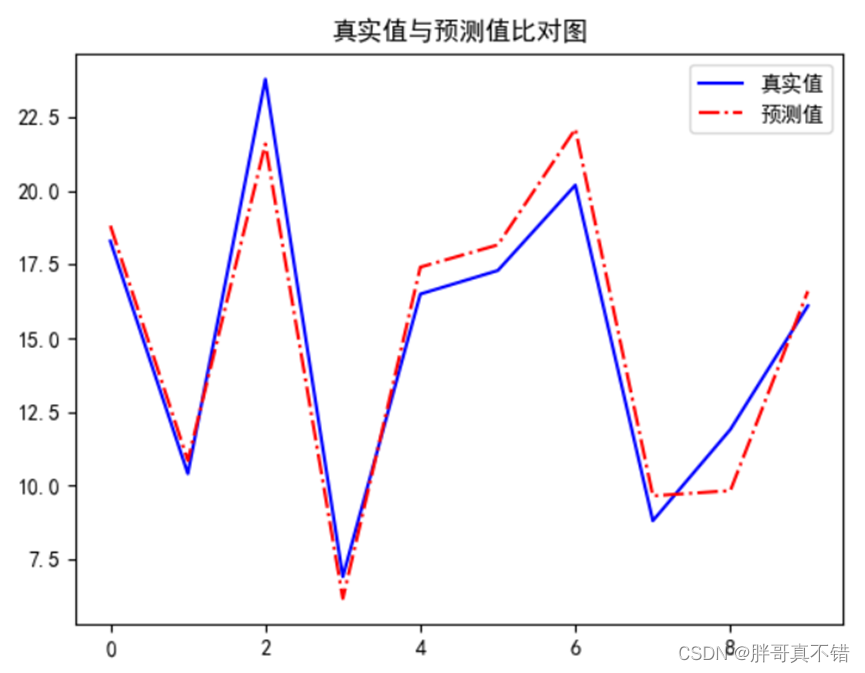

【项目实战】Python实现多元线性回归模型(statsmodels OLS算法)项目实战

说明:这是一个机器学习实战项目(附带数据代码文档视频讲解),如需数据代码文档视频讲解可以直接到文章最后获取。 1.项目背景 回归问题是一类预测连续值的问题,而能满足这样要求的数学模型称作回归模型,本项…...

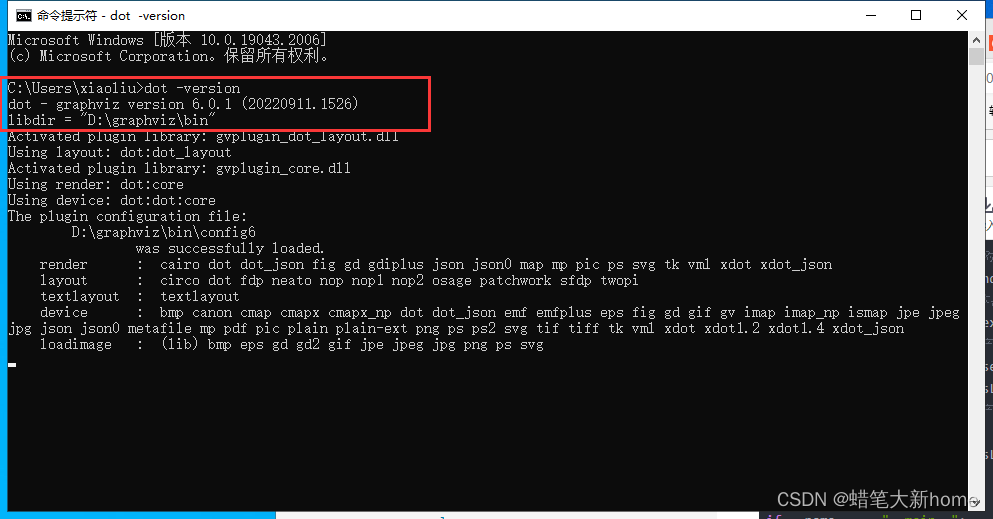

graphviz安装教程(2022最新版)初学者适用

1、首先在官网下载graphviz 下载网址:https://www.graphviz.org/download/ 2、安装。 打开第一步已经下载好的软件。点击下一步,在安装路径选择时可将安装路径修改为 D:\graphviz 接着一直点下一步,即可安装完成。 3、配置环境变量 右键…...

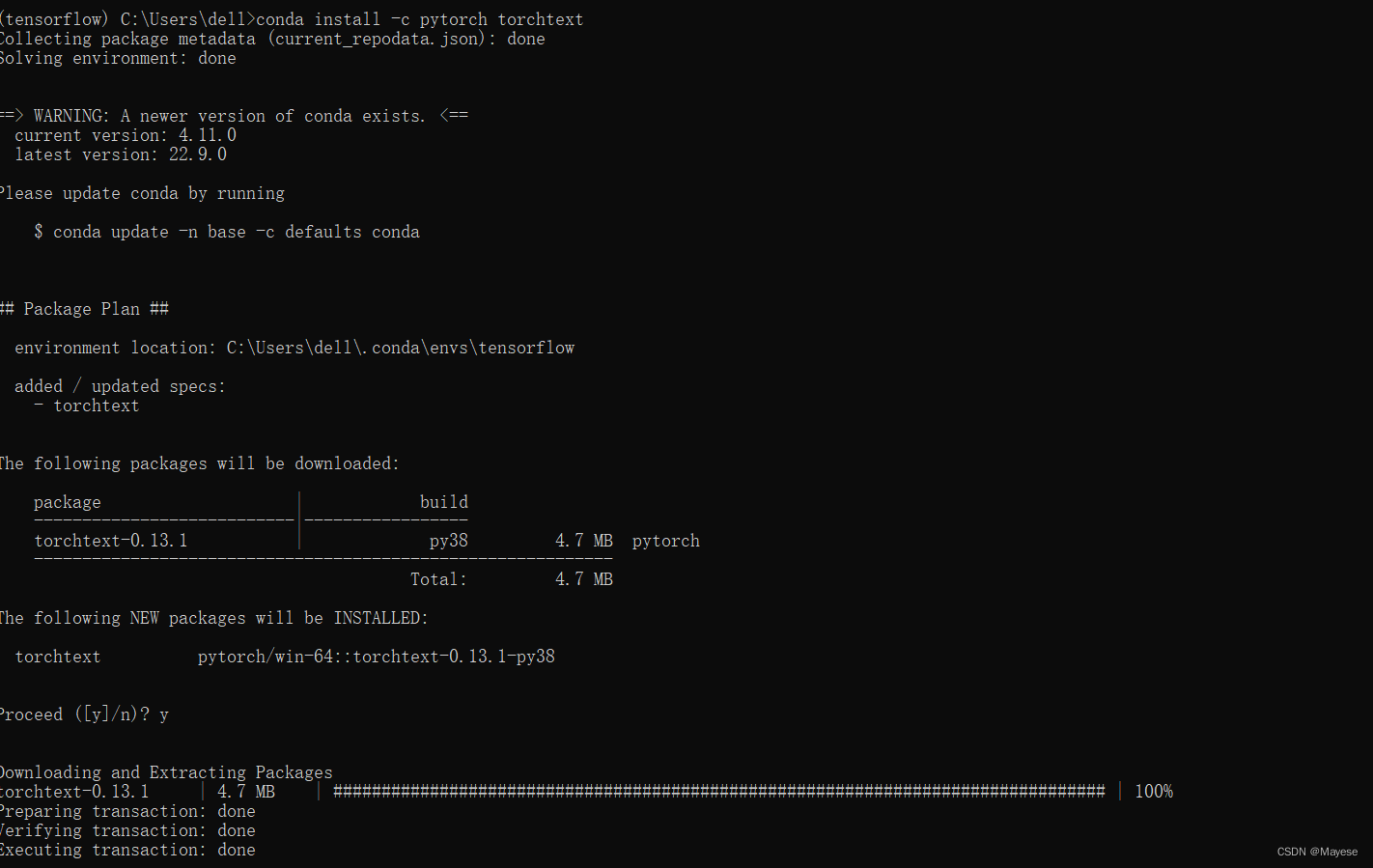

【Windows】搭建Pytorch环境(GPU版本,含CUDA、cuDNN),并在Pycharm上使用(零基础小白向)

文章目录前言一、安装CUDA1、检查电脑是否支持CUDA2、下载并安装CUDA3、下载并安装cuDNN二、安装Pytorch1、安装Anaconda2、切换清华镜像源3、创建环境并激活4、输入Pytorch安装命令5、测试三、在Pycharm上使用搭建好的环境参考文章前言 本人纯python小白,第一次使用…...

Tensorflow与CUDA、cudnn版本对应关系

不同版本的Tensorflow需对应不同的CUDA和cudnn版本,否者容易安装失败。可按下图所示,根据想要安装的Tensorflow版本,选择对应版本的CUDA和cudnn。 其中CUDA的下载链接为: CUDA Toolkit Archive | NVIDIA Developer cudnn下载链…...

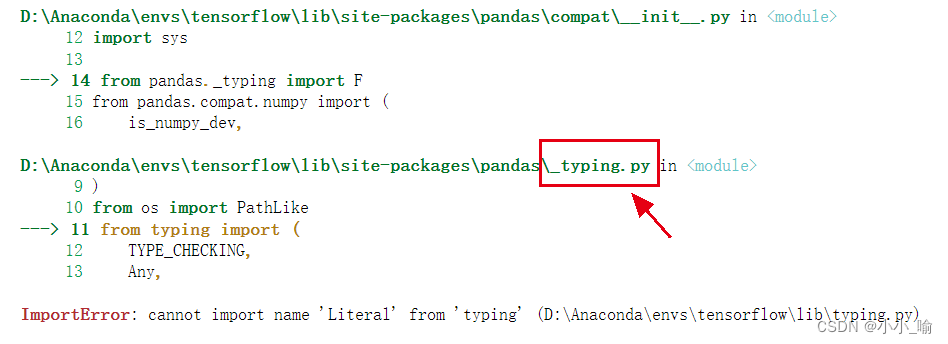

ImportError: cannot import name ‘Literal‘ from ‘typing‘ (D:\Anaconda\envs\tensorflow\lib\typing.py)

报错背景: 因为安装tensorflow-gpu版本需要,我把原来的新建的anaconda环境(我的名为tensorflow)中的python3.8降为了3.7。 在导入seaborn包时,出现了以下错误: ImportError: cannot import name Literal …...

100天精通Python(数据分析篇)——第67天:Pandas数据连接、合并、加入、添加、重构函数(merge、concat、join、append、stack、unstack)

文章目录 一、数据连接(pd.merge)1. left、right2. how3. on4. left_on、right_on5. sort6. suffixes7. left_index、right_index二、数据合并(pd.concat)1. index 没有重复的情况2. index 有重复的情况3. DataFrame合并时同时查看行索引和列索引有无重复三、数据加入(pd.…...

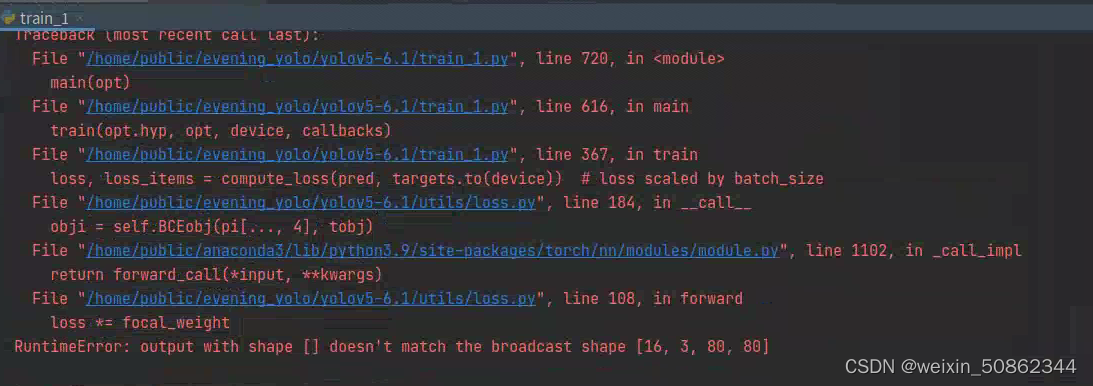

yolov5 优化系列(三):修改损失函数

1.使用 Focal loss 在util/loss.py中,computeloss类用于计算损失函数 # Focal lossg h[fl_gamma] # focal loss gammaif g > 0:BCEcls, BCEobj FocalLoss(BCEcls, g), FocalLoss(BCEobj, g)其中这一段就是开启Focal loss的关键!!&…...

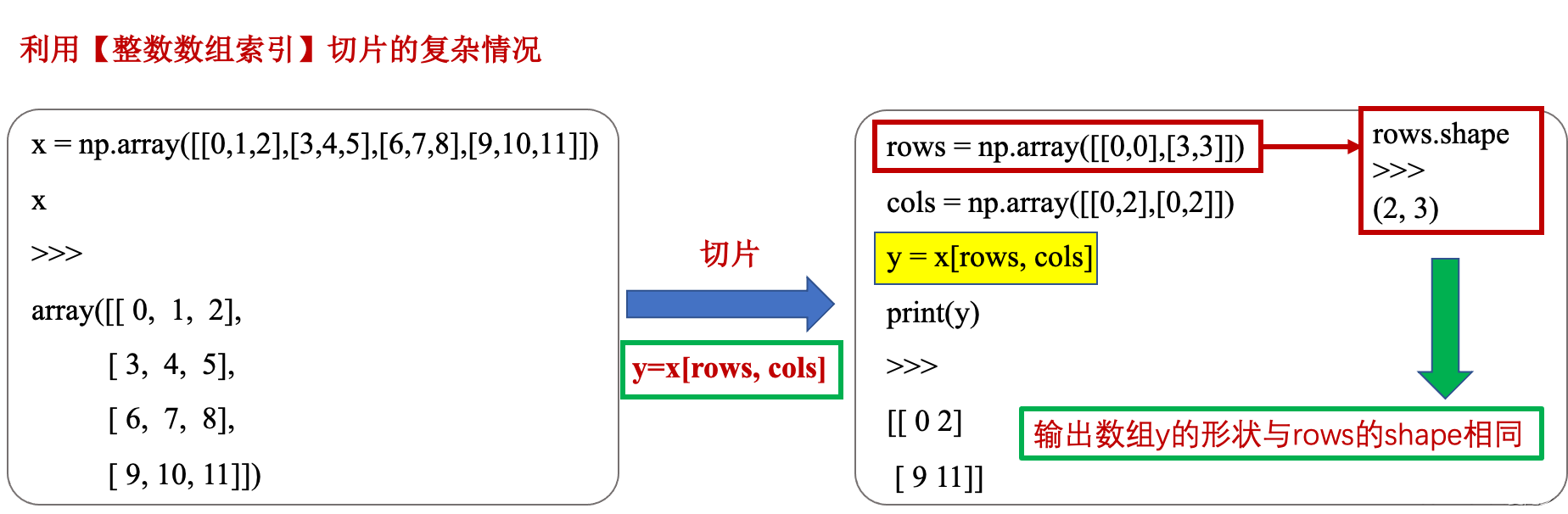

Python中数组切片的用法详解

Python中数组切片的用法详解一、python中“::-1”代表什么?二、python中“:”的用法三、python中数组切片三、numpy中的整数数组索引四、numpy中借助【切片 : 或 …与索引数组】组合进行复杂切片五、布尔索引六、花式索引一、python中“::-1”代表什么? …...

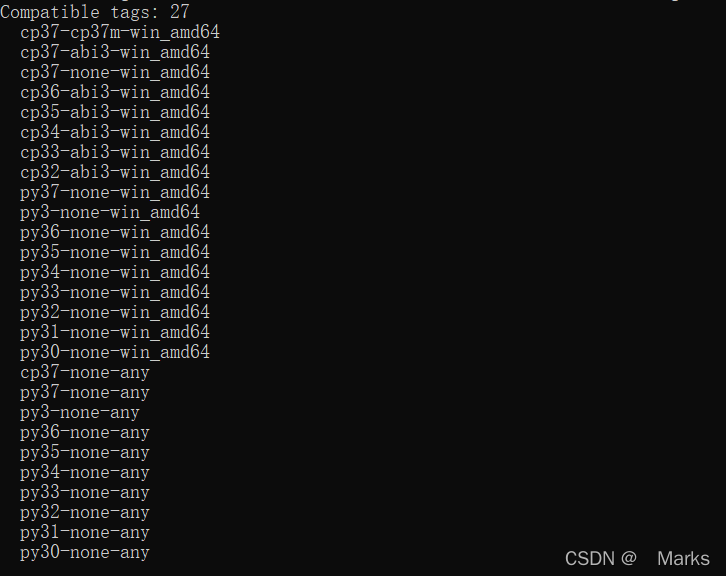

python 安装whl文件

前言 WHL文件是以Wheel格式保存的Python安装包,Wheel是Python发行版的标准内置包格式。在本质上是一个压缩包,WHL文件中包含了Python安装的py文件和元数据,以及经过编译的pyd文件,这样就使得它可以在不具备编译环境的条件下&#…...

Pycharm中安装pytorch

配置虚拟环境 为什么要安装虚拟环境?虚拟环境:把一部分内容独立出来,称之为容器。在容器中,安装我们自己想要的东西,比如不容版本的依赖包。各容器之间相互独立,互不影响。比如下载完 Anaconda 之后&#…...

Package | 解决 module ‘cv2‘ has no attribute ‘gapi_wip_gst_GStreamerPipeline‘

. 问题背景 由于这个问题出现了两回,决定记录一下。实验背景是使用opencv python库进行数据预处理,遇到报错信息如下: “ import cv2 File “/opt/conda/lib/python3.8/site-packages/cv2/init.py”, line 181, in bootstrap() File “/op…...

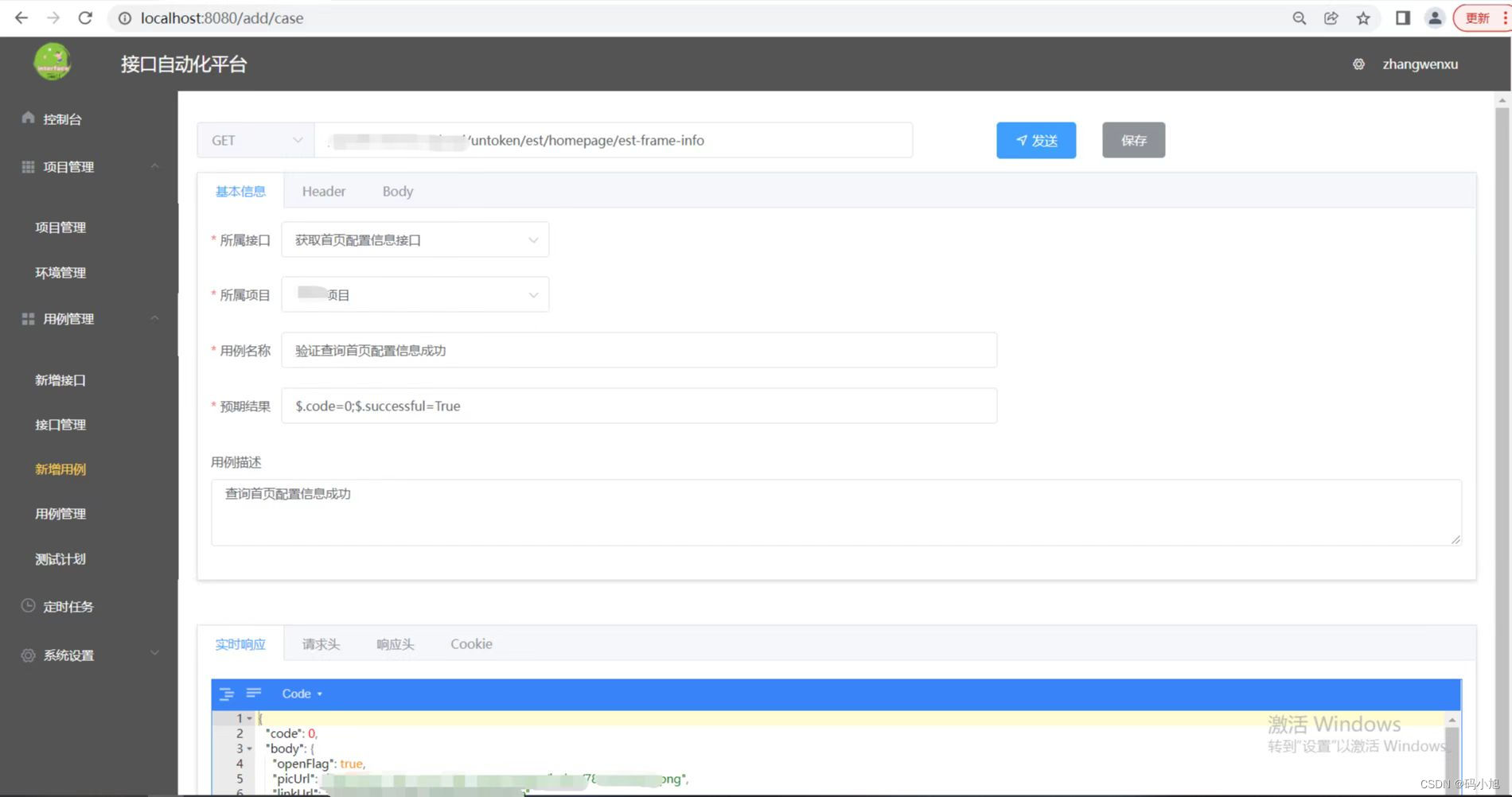

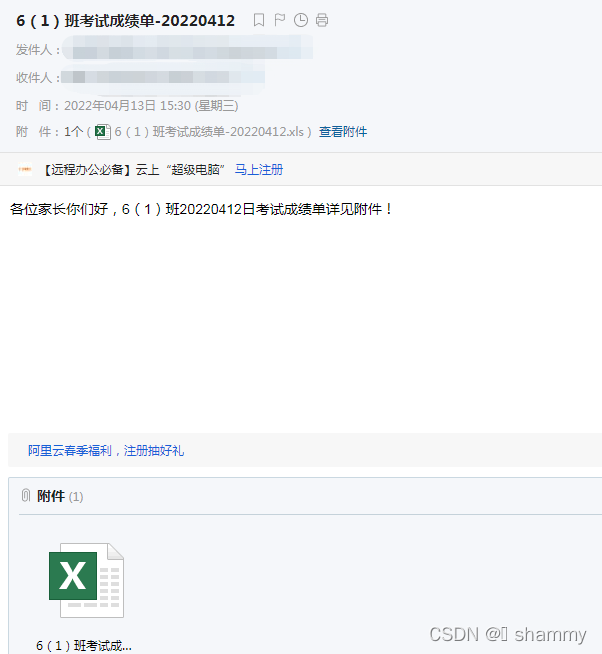

如何在项目中搭建python接口自动化框架?

文章目录前言一、框架目录介绍1、common模块读取Excel代码读取yaml代码(支持场景关联)jsonpath断言封装代码requests二次封装(get、post)configparser读取配置文件递归遍历字典常用方法log日志封装2、conf模块3、data模块4、case模…...

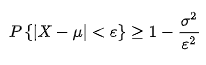

应用统计432考研复试复试提问总结精简版【一】

一、区间估计与假设检验的联系与区别 联系:二者利用样本进行推断,都属于推断统计区别: 原理: 前者是基于大概率,后者基于小概率;统计量:前者是构造枢轴量(不含未知参数,…...

Pytorch模型量化

在深度学习中,量化指的是使用更少的bit来存储原本以浮点数存储的tensor,以及使用更少的bit来完成原本以浮点数完成的计算。这么做的好处主要有如下几点: 更少的模型体积,接近4倍的减少;可以更快的计算,由于…...

已解决Encountered error while trying to install package.> lxml

已解决(pip安装第三方模块lxml模块报错)Building wheels for collected packages: lxml Building wheel for lxml (setup.py) … error error: subprocess-exited-with-error python setup.py bdist_wheel did not run successfully. note: This error o…...

距离度量 —— 闵可夫斯基距离(Minkowski Distance)

Python学习系列文章:👉 目录 👈 文章目录一、概述二、计算公式1. 闵氏距离公式2. 闵氏距离的参数 p3. 闵氏距离的缺点一、概述 闵可夫斯基距离 (Minkowski Distance),也被称为 闵氏距离。它不仅仅是一种距离,而是将多…...

python(模块)xlwt

目录一、xlwt简介二、xlwt语法1、模块安装2、模块导入3、向xls文件中写入内容4、设置写入文件的格式4.1 字体设置(font)4.2 背景颜色设置(pattern)4.3 边框设置(borders)4.4 对齐方式设置(align…...

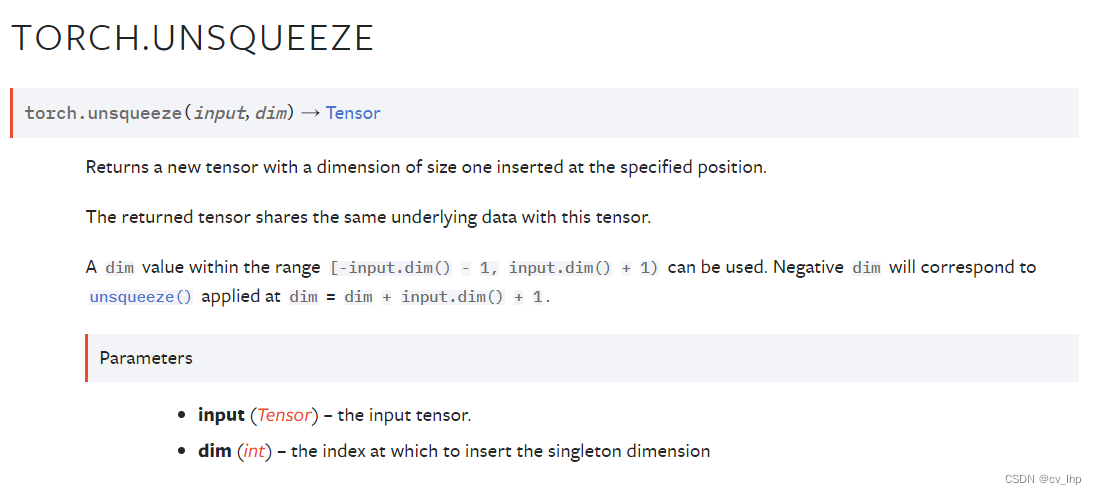

Pytorch中torch.unsqueeze()和torch.squeeze()函数解析

一. torch.squeeze()函数解析 1. 官网链接 torch.squeeze(),如下图所示: 2. torch.squeeze()函数解析 torch.squeeze(input, dimNone, outNone) squeeze()函数的功能是维度压缩。返回一个tensor(张量),其中 input…...

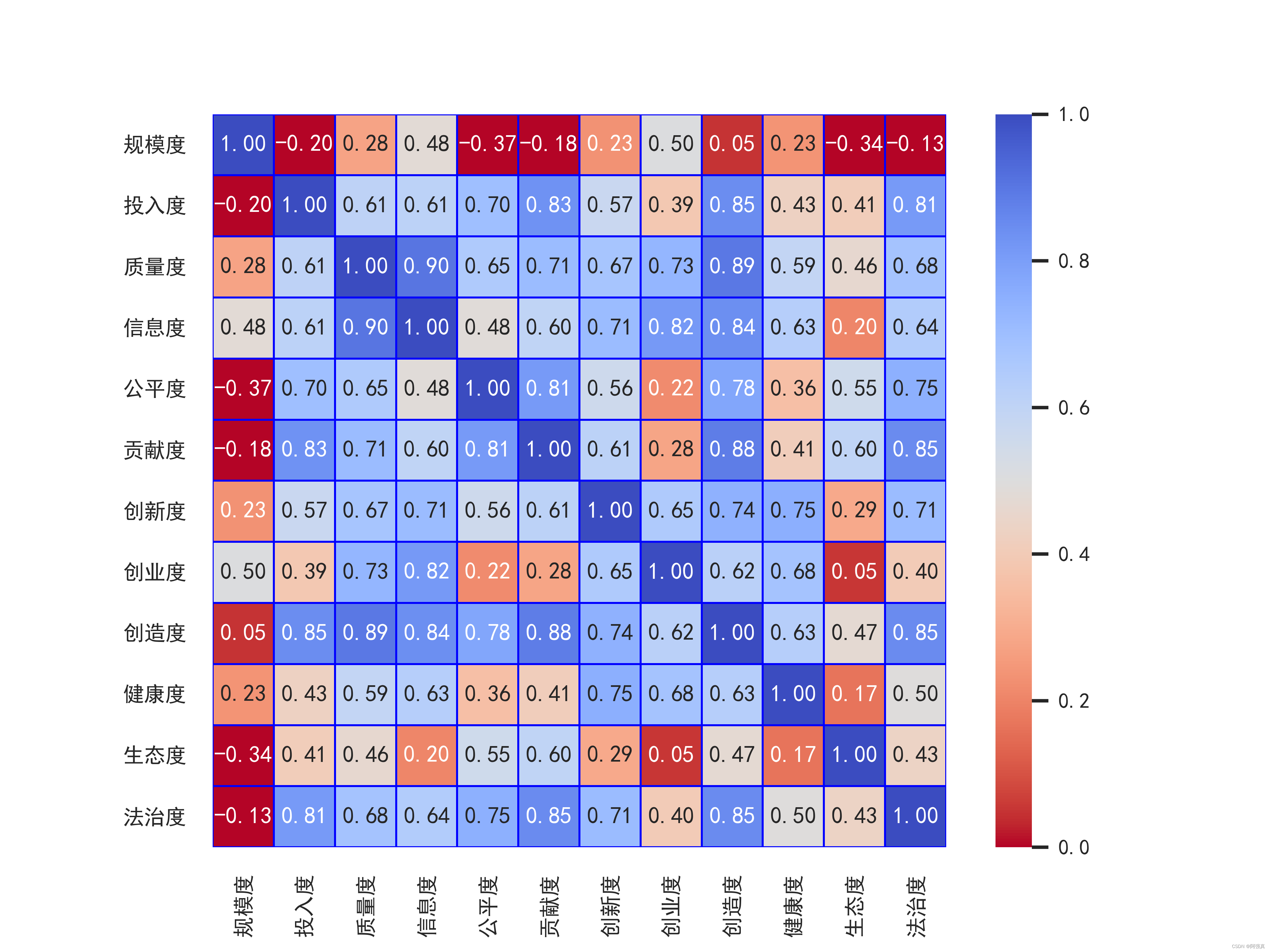

python绘制相关系数热力图

python绘制相关系数热力图一.数据说明和需要安装的库二.准备绘图三.设置配色,画出多幅图全部代码:本文讲述如何利用python绘制如上的相关系数热力图一.数据说明和需要安装的库 数据是31个省市有关教育的12个指标,如下所示。,在文…...